Только qa automation собеседование проверенные специалисты, которым мы доверяем и которых можем советовать другим. В форме стендапа здесь иронически подаются проблемы, с которыми сталкиваются представители этого поколения. Реклама продает не через яркую картинку, а через близость и соучастие. Единого правильного метода нет, ведь подходы к анализу разных аудиторий будут отличаться. Например, бренд уходовой косметики считает, что женщины покупают его товар, чтобы только ухаживать за собой.

Тщательная и грамотная проработка этих файлов важна и для целей оптимизации расхода краулингаового бюджета веб-сайта. Роботы Google далеко не всегда четко следуют нашим указаниям, но часто ориентируются именно на них. Поэтому своевременное закрытие «лишних» страниц позволит исключить их из списка сканирования, а открытие важных URL поможет роботам не пройти мимо. Поисковые системы далеко не сразу вносят в свои базы данных новые страницы сайтов. Рассмотрим, что такое «краулинговый бюджет» и почему его нужно оптимизировать. Например, на нашем сайте количество страниц в индексации составило 150, количество обращений роботов — 67.

Если необходима переадресация на другую страницу, код будет 301 («Перейти сюда вместо»). Эти коды считаются идеальными, так как ведут бота к полезному контенту. Сервис подскажет конкретные действия, которые можно предпринять для увеличения скорости загрузки. Это очень распространенная проблема на страницах категорий электронной коммерции, где похожие продукты могут быть перечислены в нескольких категориях. Как веб-мастер, вы должны приложить все усилия, чтобы веб-страницы загружались максимально быстро на всех устройствах. Один из способов, которые они используют для распознавания важных страниц, это подсчет внешних и https://deveducation.com/ внутренних ссылок, которые ведут на страницу.

Бот не должен перейти по ссылке, которая будет закрыта в этот атрибут. На самом деле внутренняя перелинковка — это основная проблема крупных сайтов. На скриншоте показан сайт, на 50% страниц которого ведёт менее 7 внутренних ссылок.

Частая ошибка — важные продвигаемые страницы попадают в эти 50%. С учётом количества сайтов и страниц во всём мире, важно научиться управлять краулинговым бюджетом в пользу своего ресурса. Частая проблема сайтов-пациентов – низкая скорость обхода страниц поисковыми ботами. Зачастую сталкиваемся с тем, что бот Яндекса обходит в 10–20 раз больше страниц, чем основной и мобильный боты Google. Значительно большую проблему представляют собой изолированные страницы, на которые не ведёт ни одна ссылка. Оцените, нужна ли вообще эта страница, и если она должна быть проиндексирована – исправьте проблему.

Полученная прибыль — не единственный показатель правильно отлаженной системы продаж в компании. Чтобы проанализировать эффективность работы бизнеса и построить результативную стратегию продаж, нужно обратить внимание на следующие метрики. Если у вас нет навыков администрирования серверов, содержимое лога вас, безусловно, напугает.

Как Рассчитывается Краулинговый Бюджет Сайта

- Как минимум, снижайте количество таких блоков на посадочных страницах.

- Добавьте в sitemap.xml правило lastmod для страниц, контент которых остался прежним с момента последней индексации.

- Страницы, которые должны быть в индексе, мы определяем в ScreamingFrog.

- С его помощью лимит не будет тратиться на то, что в последнее время не изменялось.

- Например, если у вас есть несколько страниц, ориентированных на одни и те же ключевые слова, и контент на этих страницах похож, то Google может рассматривать это как дублирующийся контент.

- Однако даже у них есть определенные ограничения в количестве страниц, которые поисковые роботы посещают ежедневно.

В них все документы динамические с использованием визуализации и JS-фреймворков. Поддержание технической оптимизации сайта — процесс бесконечный, поэтому надо быть готовым постоянно вносить правки и отслеживать улучшения. Потерянные страницы — это страницы, на которые невозможно попасть через внутренние ссылки. При добавлении заголовка ускоряется загрузка страницы и снижается нагрузка на сервер, а значит, значительно ускоряется скорость индексации страницы. Заголовок Last-Modified сообщает браузеру пользователя или роботу ПС информацию о дате и времени последнего изменения текущей страницы. Если контент присутствует на странице, код ответа будет 200 («ОК»).

Как В 2 Раза Увеличить Продажи С Сайта На Том Же Трафике Решения Для Войс Таргетинга

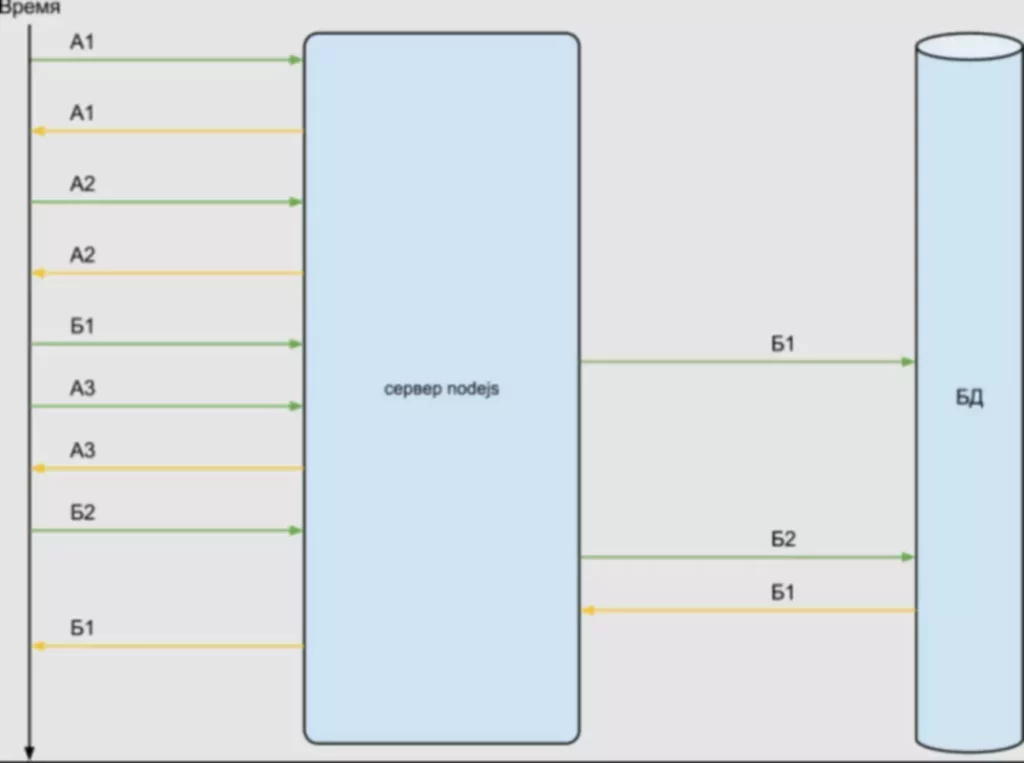

Краулинговый бюджет сайта определяет количество документов, которое поисковый робот должен обойти за одно посещение или другой временной промежуток. Например, если бот обходит 60 URL-адресов в сутки, то на ваш сайт выделяется 1800 страниц краулингового бюджета ежемесячно. Краулинговый бюджет является критическим ресурсом для успешной индексации, особенно для крупных веб-проектов. В условиях растущей конкуренции краулинговый бюджет определяет эффективность сканирования сайта и скорость обновления страниц и попадания в индекс.

Пока проблема существует, Google советует использовать динамический рендеринг. Нужно ускорить отображение контента, чтобы страница быстрее загружалась. Есть много возможностей, например, кэширование на длительный срок. Посмотреть на страницу глазами поискового бота можно с помощью этого бесплатного инструмента. Он покажет Header ответ, код, который видит бот, а также соберет в список внутренние и внешние ссылки и укажет, какие из них индексируются. В Google Search Console на вкладке Статистика сканирования можно увидеть общую картину — количество просканированных ботами страниц.

При использовании JS-страниц нужно заранее подумать о том, чтобы поисковикам было удобно их сканировать. Помним, в начале статьи мы говорили о том, как роботы обходят веб-ресурсы. Разобраться с этим надо обязательно, так как они не несут пользы ни посетителям, ни поисковикам.

Чтобы новые версии попали в выдачу, их должны просканировать и проиндексировать поисковые роботы — краулеры. Проблема в том, что у них есть лимит на количество страниц, которые они могут обойти за день. Рассказываем, как узнать краулинговый бюджет сайта и 12 способов его оптимизировать. Краулинг представляет собой процесс обход поисковым роботом (краулером, пауком) документов сайта для последующего их добавления в индекс. Любая поисковая система старается оптимизировать процесс индексации сайтов, выделяя на каждый из них лимиты.

Остро ощущаются проблемы с неправильно настроенным SEO-продвижением, техническими ошибками сайта, неудобным UI/UX-дизайном и провалами в определенных элементах продажи воронки. Для анализа можно использовать ПО для настольного компьютера, например, GamutLogViewer или Screaming Frog Log File Analyser (условно-бесплатный), либо внешние сервисы типа splunk.com. Но внешние сервисы обычно рассчитаны на большие объёмы данных, и стоят дорого.

Необходимо как можно скорее выявить причины и устранить их, чтобы не терять в индексации. Если речь о крауд-маркетинге, ссылки необходимо размещать только на трастовых сайтах, которым доверяют поисковики. И даже если пользователю кажется, что анкорная ссылка выглядит более естественно, увы, поисковые системы считают наоборот — они ценят краулинговый бюджет это безанкорные ссылки. В нормальных условиях количество страниц для сканирования должно постоянно увеличиваться (при условии, что вы регулярно добавляете новый контент на сайт). Если вы не вносите никаких изменений, шаблон должен быть похожим, если вы сравниваете два периода времени.

74% пользователей, покупающих в интернете, читают не менее пяти отзывов других покупателей на товар или услугу. 83% из них отдельно ищут упоминания компании в Google, а еще 34% — в YouTube. В то же время, автоматизация обходится дешевле, чем работа специалистов-людей, а уменьшение количества рутинных задач снижает риски выгорания сотрудников. Особенно, если видите непонятные просадки в статистике продаж. Неработающая «корзина» или сломанный скрипт оплаты в разы увеличит показатель отказов, даже если пользователь хотел завершить покупку.